Figure AI发布Helix模型,机器人技术实现重大突破

AI导读:

Figure AI发布首款能对人形机器人上半身进行高频率、连续控制的视觉-语言-动作(VLA)模型Helix,解决了人形机器人领域的多个长期挑战,搭载Helix的机器人能够响应自然语言指令,识别并拾取几乎所有小型家居物品,包括成千上万从未见过的物品。Figure正在进行一轮目标15亿美元的融资,估值预计达到395亿美元。

在2月初终结与OpenAI的AI模型合作后,美国机器人创业公司Figure AI周四公开了背后的原因:公司已经研发出更强大的通用具身智能模型Helix。

(来源:Figure AI)

Figure AI强调,Helix是首款能对整个人形机器人上半身(涵盖头部、躯干、手腕及手指)执行高频、连续控制的视觉-语言-动作(VLA)模型。该模型通过直接转化视觉语言模型中的丰富语义知识为机器人动作,成功攻克了人形机器人领域的多项长期难题,显著减少了为每个动作进行大量训练的需求。

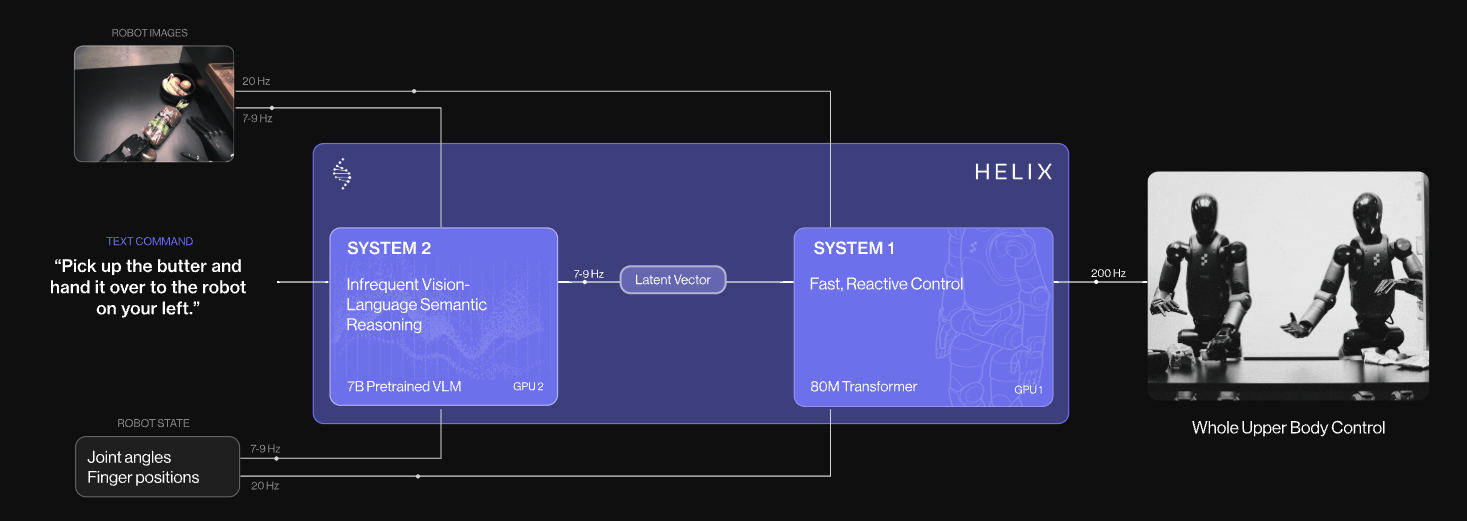

为了平衡视觉语言模型的“通用性不足”与机器人视觉运动策略的“快速但不通用”问题,Figure设计了一套互补系统。这两套系统通过端到端训练实现高效通信。

如下图所示,系统2是一个拥有70亿参数的开源、开放权重端侧互联网预训练视觉语言模型,负责理解场景和自然语言;系统1则是一个拥有8000万参数的快速反应视觉运动策略,能够将系统2理解的语义转化为每秒200次的精确连续机器人动作。

(来源:Figure AI)

Figure透露,Helix的训练仅使用了500小时的高质量监督数据,这一数据量不到之前收集的VLA数据集的5%,且无需多机器人数据或多阶段训练。

作为这项科技突破的成果,搭载Helix的机器人现在能够响应自然语言指令,识别并拾取几乎所有小型家居物品,包括成千上万从未见过的物品。在公司提供的案例中,机器人在听到“拿起那个仙人掌”或“拿起沙漠里的东西”时,都能准确选择最接近的玩具,成功从一堆物品中拎出仙人掌玩具。

在实际操作中,配备Helix的Figure机器人仅凭简单的“捡起XX”指令,就成功完成了成千上万次的任务,无需任何提前演示或额外编程。

更令人惊叹的是,Helix是首款能在人形机器人上协同运行的AI模型,使两台机器人能够协作完成一个共享的、长期的操作任务。

在演示案例中,两台模型权重相同的Figure机器人面对一堆首次见到的杂物,自行分类并放置在柜子、冰箱、盆子等收纳位置。

本次挑战的难点在于,研究人员故意将一些物品放在另一台机器人面前,这意味着两台机器人必须协作才能完成摆放。

演示中,机器人之间不仅能互相理解对方并衔接动作,还展现出一种特殊的默契——在交接物品时,两台机器人一定会互相对看一眼,确认彼此的“眼神”。

在演示的最后阶段,Figure展示了更高水平的协作:左边的机器人将果盆拉过来,右边的机器人顺手将水果放入,然后左边的机器人再将果盆放回原位。

在完成首次VLA模型在多机器人之间灵活、可扩展的协作操作后,Figure表示这只是“可能性的冰山一角”,公司期待看到Helix规模扩大1000倍后的潜力。

Figure还透露,Helix完全能够在嵌入式低功耗GPU上运行,现已具备商业部署条件。

据早前报道,在发布机器人AI系统演示的同时,Figure正进行一轮目标15亿美元的融资,估值预计达到395亿美元。相比之下,去年该公司融资时的估值仅为26亿美元,这一对比凸显了当前机器人赛道的火爆程度。

(文章来源:科创板日报)

郑重声明:以上内容与本站立场无关。本站发布此内容的目的在于传播更多信息,本站对其观点、判断保持中立,不保证该内容(包括但不限于文字、数据及图表)全部或者部分内容的准确性、真实性、完整性、有效性、及时性、原创性等。相关内容不对各位读者构成任何投资建议,据此操作,风险自担。股市有风险,投资需谨慎。如对该内容存在异议,或发现违法及不良信息,请发送邮件至yxiu_cn@foxmail.com,我们将安排核实处理。