A股视觉认知概念股午后走强,豆包VideoWorld模型引领创新潮流

AI导读:

2月10日,A股视觉认知概念股午后大幅走强,创业板星宸科技等个股涨停。豆包公司发布的VideoWorld模型在业界首次实现无需依赖语言模型,仅凭视觉信息认知世界,引领AI视觉学习创新潮流。随着AI大模型多模态能力持续提升,国内AI应用有望从中受益。

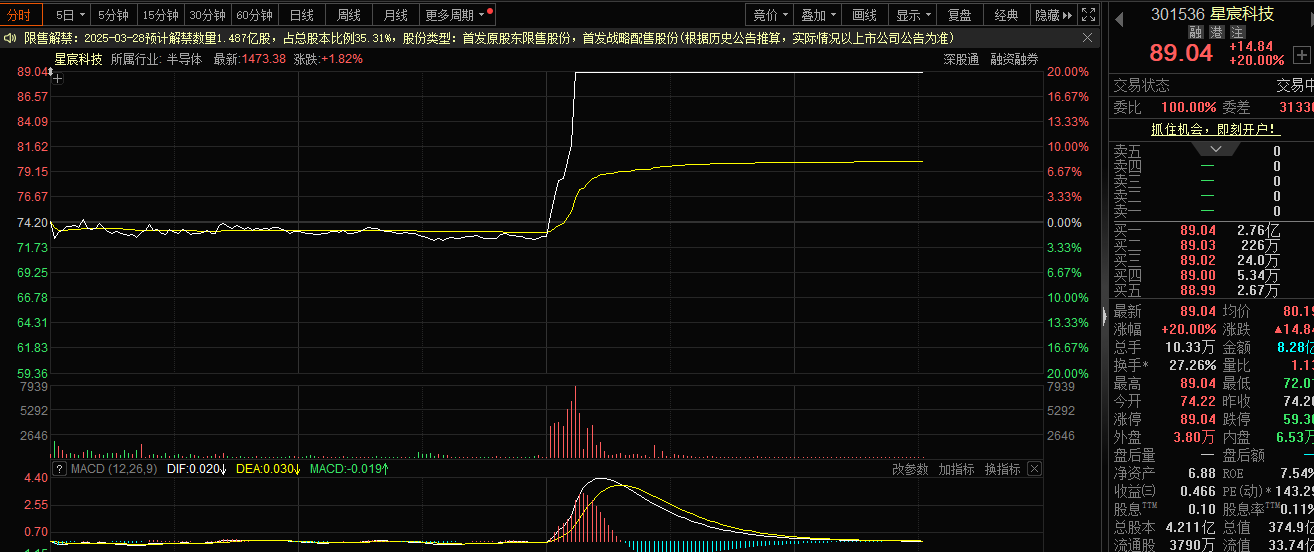

2月10日,A股市场中的视觉认知概念板块午后迎来强势反弹,创业板明星企业星宸科技股价直线拉升直至涨停,与此同时,全志科技、富瀚微、虹软科技等个股也纷纷大幅冲高,展现出市场对这一领域的强烈关注。

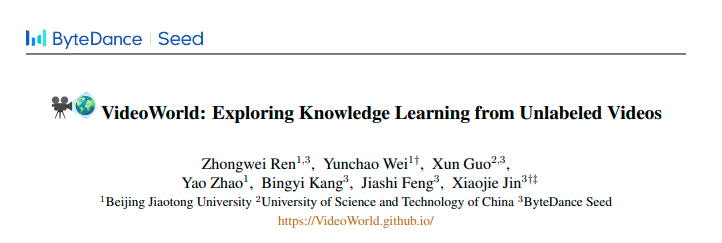

从消息面来看,豆包公司近期发布了名为“VideoWorld”的视频生成实验模型。据悉,该模型在业界开创了先河,无需依赖语言模型,仅凭“视觉信息”即可实现对世界的认知。换言之,VideoWorld通过浏览和分析视频数据,能够使机器掌握推理、规划和决策等一系列复杂能力。尤为值得一提的是,在仅拥有300M参数量的条件下,VideoWorld已展现出令人瞩目的模型性能。

目前,该项目已经实现了代码与模型的全面开源,为行业内外的研究者提供了宝贵的学习和实践资源。

以往,大多数模型在学习知识时主要依赖于语言或标签数据,而很少涉及纯视觉信号的学习。VideoWorld则打破了这一常规,通过去除语言模型,实现了统一执行理解和推理任务的能力。这一创新之举无疑为AI视觉学习领域带来了新的突破。

那么,VideoWorld究竟是如何实现这一壮举的呢?

豆包大模型团队透露,VideoWorld基于一种名为潜在动态模型(Latent Dynamics Model,LDM)的技术架构。该模型能够高效地压缩视频帧间的变化信息,在保留丰富视觉信息的同时,对关键决策和动作相关的视觉变化进行压缩,从而显著提升了知识学习的效率和效果。这一技术特点使得VideoWorld在不依赖任何强化学习搜索或奖励函数机制的前提下,仍然能够达到专业5段9x9围棋的水平,并在多种环境中执行机器人任务。

然而,尽管VideoWorld取得了诸多成就,但其在真实世界环境中的应用仍面临诸多挑战。其中,高质量视频生成和多环境泛化等问题尤为突出。由于视频中存在大量冗余信息,这会对模型的学习效率产生较大影响,使得视频序列的知识挖掘效率显著落后于文本形式,从而不利于模型对复杂知识的快速学习。

大模型的视觉理解能力一直是AI领域的前沿研究方向之一。对人类而言,与语言相比,“用眼睛看”无疑是一种更为直观和自然的认知方式。正如李飞飞教授在多年前的TED演讲中所提到的那样,“幼儿可以不依靠语言理解真实世界”。这一观点在AI视觉学习领域同样适用。

简而言之,AI视觉学习需要大模型能够准确理解物品、空间和场景的整体含义,并根据识别内容进行复杂的逻辑计算。在此基础上,模型还需要根据图像信息更细腻地表述并创作内容。随着AI视觉学习能力的不断提升,我们有理由相信未来将有更多的AI应用被催发出来。

长城证券此前发布的研报也指出,国内AI大模型的多模态能力正在持续提升。以快手可灵AI大模型和字节豆包AI大模型为例,它们在视频生成方面的效果正在不断攀升,包括精准语义理解、一致性多镜头生成、动态运镜等功能都得到了显著提升。受益于底层技术能力的不断升级,国内AI应用正在持续迭代更新,token调用量也呈现出持续增长的趋势。这无疑为AI应用的未来发展提供了广阔的空间和机遇。

(文章来源:科创板日报)

郑重声明:以上内容与本站立场无关。本站发布此内容的目的在于传播更多信息,本站对其观点、判断保持中立,不保证该内容(包括但不限于文字、数据及图表)全部或者部分内容的准确性、真实性、完整性、有效性、及时性、原创性等。相关内容不对各位读者构成任何投资建议,据此操作,风险自担。股市有风险,投资需谨慎。如对该内容存在异议,或发现违法及不良信息,请发送邮件至yxiu_cn@foxmail.com,我们将安排核实处理。