Deepseek R1模型引发算力需求热议,AI芯片初创公司迎来新机遇

AI导读:

Deepseek R1模型的推出引发了对算力需求的广泛讨论。AI芯片初创公司认为这是一个巨大机会,随着Deepseek开源模型的普及,推理芯片和算力的需求正在攀升。同时,Deepseek也反映了算力资源的紧张,但整体需求依然乐观。

《科创板日报》2月8日讯,Deepseek R1模型的横空出世,不仅在全球范围内掀起了一场技术革命,还一度引发了对算力长期需求的广泛讨论,甚至导致了英伟达股价的短期波动。

面对这一新兴模型的出现,算力需求是否会萎缩成为业界关注的焦点。然而,AI芯片初创公司对此持不同看法。在他们眼中,Deepseek R1的推出并非威胁,而是一个前所未有的发展机遇。随着越来越多的客户采用和搭建Deepseek开源模型,对推理芯片和算力的需求正呈现出显著的增长趋势。

以英伟达竞争对手之一的Cerebras Systems为例,该公司主要为客户提供AI芯片,并能够通过自家的计算集群提供云服务。去年8月,Cerebras Systems发布了号称“全球最快的AI推理解决方案”的Cerebras Inference。自Deepseek R1模型发布以来,Cerebras Systems迎来了前所未有的服务需求高峰。公司CEO Andrew Feldman在接受CNBC采访时表示,开发者们非常渴望用Deepseek R1这样的开源模型来取代OpenAI昂贵且封闭的模型。他认为,随着价格的下降,Deepseek R1将推动全球使用范围的扩张,类似于之前的PC和互联网行业,AI也正走在一条类似的长期增长之路上。

另一家AI芯片制造商Etched也感受到了Deepseek带来的变革。自Deepseek发布推理模型以来,已有数十家公司向Etched表达了合作意愿。因此,Etched正在将支出从训练集群转向推理集群,以满足日益增长的算力需求。Etched方面表示,Deepseek-R1证明了推理计算已成为每个主要模型供应商的“最先进”方法,而推理思考并不便宜。为了将这些模型扩展到数百万用户,将需要越来越多的算力。

AI芯片初创公司d-Matrix的首席执行官Sid Sheth也对此表示赞同。他认为,从Deepseek的例子中可以看到,较小的开放模型可以训练得与更大的专有模型一样强大,甚至更强,而且可以以极低的成本实现。这种小型模型的普及将进一步催化推理时代的到来。

在芯片初创公司和业内分析师们看来,Deepseek不仅是一个技术创新的典范,更有可能加速“从训练到推理”的AI周期,促进新芯片技术的采用。Morningstar半导体分析师Phelix Lee指出,AI训练是构建一个工具或算法的过程,而推理则是将这个工具实际应用于现实场景中的过程。虽然AI训练非常依赖算力,但推理可以在不那么先进的芯片上进行,这些芯片可以执行较窄范围的任务。

然而,Deepseek日前的表现也反映出算力资源的紧张。2月6日,Deepseek突然暂停了其API服务的充值功能,按钮显示灰色不可用状态。官方声明称,由于当前服务器资源紧张,为避免对客户造成业务影响,已暂停API服务充值。但存量充值金额仍可继续调用。这一事件再次凸显了算力资源在AI行业中的重要性。

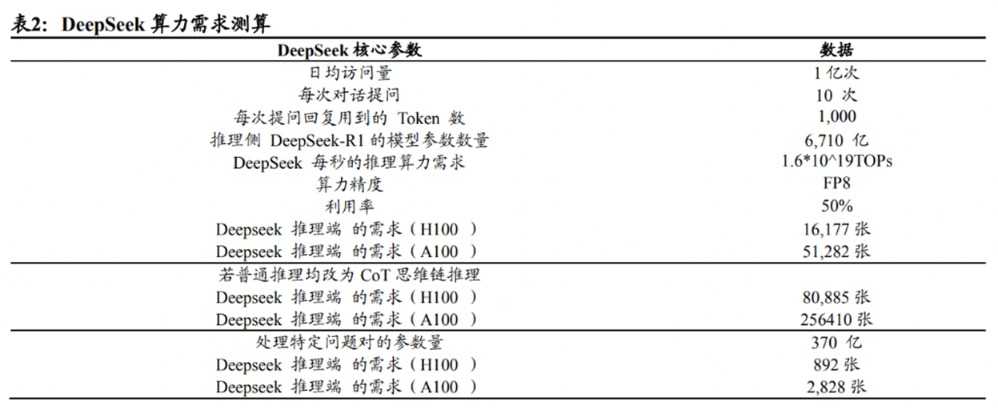

据国泰君安测算,假设Deepseek日均访问量为1亿次、每次提问10次、每次提问的回复用到1000个token(约对应750个英文字母),则Deepseek每秒的推理算力需求为惊人的1.6*10^19TOPs。在这种普通推理情境下,如果Deepseek采用的是FP8精度的H100卡做推理、利用率为50%,那么推理端H100卡需求为16177张、A100卡需求为51282张。这一数据再次证明了算力资源在AI行业中的巨大需求。

国泰君安进一步表示,在以Deepseek为首的低成本推理模型逐渐普及的背景下,推理成本及价格的大幅削减势必会带来应用侧的繁荣。由此将拉动成倍数的总算力需求提升。未来的AI投入将不再盲目追求“大力出奇迹”的Scaling Law,而是逐渐将重心从预训练转向推理。东吴证券认为,训练+推理的整体需求依然乐观。参考从2G到4G流量费用不断降低的历程,虽然单价下降,但因为用量的指数级提升,导致整体市场规模依然快速增大。

回看19世纪,英国经济学家杰文斯发现,当通过技术提升实现煤炭使用效率提高、成本下探时,煤炭消费量反而会增加。这一现象被称为环境经济学中的“杰文斯悖论”。站在160年后的今天,当Deepseek通过技术降本为AI应用打开更多落地场景时,“杰文斯悖论”或许也将在AI行业应验。随着Deepseek等低成本推理模型的普及和算力需求的不断增长,AI行业将迎来更加繁荣的发展。

(文章来源:科创板日报)

郑重声明:以上内容与本站立场无关。本站发布此内容的目的在于传播更多信息,本站对其观点、判断保持中立,不保证该内容(包括但不限于文字、数据及图表)全部或者部分内容的准确性、真实性、完整性、有效性、及时性、原创性等。相关内容不对各位读者构成任何投资建议,据此操作,风险自担。股市有风险,投资需谨慎。如对该内容存在异议,或发现违法及不良信息,请发送邮件至yxiu_cn@foxmail.com,我们将安排核实处理。