DeepSeek发布推理系统概览,成本利润率刷新AI盈利纪录

AI导读:

DeepSeek发布《DeepSeek-V3/R1推理系统概览》技术文章,首次披露成本利润率高达545%,刷新全球AI大模型领域盈利天花板,展示了技术实力与商业潜力,标志着AI盈利闭环已从理想变为现实。

周六,国内AI大模型公司Deepseek官方账号在知乎首次发布《DeepSeek-V3/R1推理系统概览》技术文章,详细公开了其推理系统的核心优化方案,并首次披露了成本利润率等关键数据,这一举动在行业内引发了强烈震动。

数据表明,若按理论定价计算,DeepSeek的单日成本利润率竟高达545%,这一惊人数字刷新了全球AI大模型领域的盈利纪录。

业内专家分析指出,DeepSeek的开源策略与卓越的成本控制能力正逐步打破AI领域的资源垄断局面。此次DeepSeek“透明化”的披露策略,不仅充分展示了其强大的技术实力与广阔的商业潜力,更向整个行业传递了一个明确信号:AI大模型的盈利闭环已从理想变为现实。

3月1日,DeepSeek在知乎开设官方账号,并发布了《DeepSeek-V3/R1推理系统概览》技术文章,首次公布了模型推理系统的优化细节,并披露了成本利润率等关键信息。

文章明确指出,DeepSeek-V3/R1推理系统的优化目标在于实现更大的吞吐量和更低的延迟。为实现这一目标,DeepSeek采用了大规模跨节点专家并行(EP)方案,尽管这增加了系统的复杂性。文章深入探讨了如何使用EP技术来增长批量大小(batch size)、隐藏传输耗时以及实现负载均衡。

值得注意的是,文章还首次公开了DeepSeek的理论成本和利润率等关键数据。

据DeepSeek官方披露,DeepSeek V3和R1的所有服务均采用H800 GPU,并使用与训练一致的精度,即矩阵计算和dispatch传输采用FP8格式,core-attention计算和combine传输采用BF16格式,从而最大程度保证了服务效果。

此外,针对白天和晚上服务负荷的差异,DeepSeek设计了一套机制:在白天负荷高时,使用所有节点部署推理服务;而在晚上负荷低时,则减少推理节点,转而用于研究和训练。

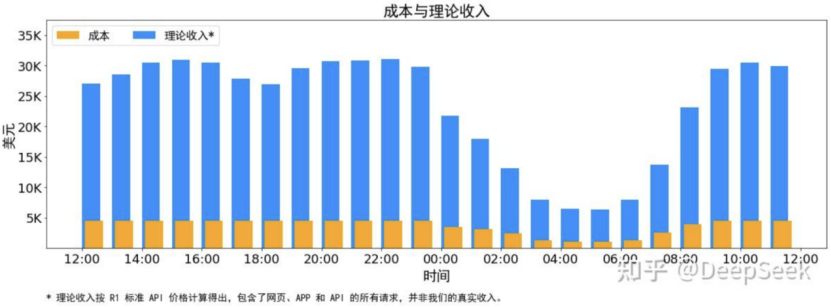

在最近24小时(2025年2月27日12:00至28日12:00)的统计周期内,若按GPU租赁成本2美元/小时计算,DeepSeek的日均成本为87072美元;而若按R1定价(输入1元/百万token、输出16元/百万token)计算,其单日收入可达562027美元,成本利润率高达545%。

然而,DeepSeek官方也坦诚表示,实际上并没有这么多收入,因为V3的定价更低,且收费服务仅占一部分,夜间还会有折扣。

DeepSeek的高利润率得益于其创新的推理系统设计,该设计主要包括大规模跨节点专家并行(EP)、计算通信重叠与负载均衡优化三大技术支柱。其中,EP技术通过提升吞吐与响应速度,针对模型稀疏性采用策略扩展总体批处理规模,显著提升GPU利用率;而部署单元的动态调整则平衡了资源分配与任务需求。

在计算与通信方面,DeepSeek通过重叠隐藏延迟技术,在Prefill阶段实现计算与通信并行,同时在Decode阶段拆分attention为多级流水线,最大限度减少通信开销。

此外,全局负载均衡器针对不同并行模式设计,确保各GPU的计算量、通信量及KVCache占用均衡,避免资源浪费。

简而言之,EP技术如同“多人协作”,将模型中的“专家”分散到多张GPU上进行计算,大幅提升Batch Size,充分利用GPU算力,同时降低内存压力,实现更快响应。

DeepSeek在工程层面也采取了进一步的成本压缩措施。通过昼夜资源调配,白天全力支持推理服务,夜间闲置节点转用于研发训练,最大化硬件利用率;同时,通过KVCache硬盘缓存减少重复计算,缓存命中率高达56.3%,大幅降低算力消耗。

此次DeepSeek披露的数据不仅验证了其技术路线的商业可行性,更为行业树立了高效盈利的标杆。其模型训练成本仅为同类产品的1%—5%,此前发布的DeepSeek-V3模型训练成本仅557.6万美元,远低于OpenAI等巨头;在推理定价方面,DeepSeek-R1的API定价仅为OpenAI o3-mini的1/7至1/2,其低成本策略加速了市场渗透。

业内专家指出,DeepSeek的开源策略与成本控制能力正在打破AI领域的资源垄断。此次“透明化”披露不仅展示了其技术实力与商业潜力,更标志着AI技术从实验室迈向产业化的关键转折。

中信证券认为,Deepseek在降低模型训练成本方面的实践,将激励科技巨头采用更为经济的方式加速前沿模型的探索和研究,同时解锁和落地大量AI应用。算法训练带来的规模报酬递增效应以及单位算力成本降低对应的杰文斯悖论等,均预示着科技巨头将在AI算力领域进行持续、规模的投入。

本周以来,DeepSeek开启“开源周”,给人工智能领域带来了一系列重大发布。回顾DeepSeek这五天开源的内容,信息量巨大:

周一,DeepSeek宣布开源FlashMLA,这是专为Hopper GPU设计的高效MLA解码内核,针对可变长度序列进行了优化,并已投入生产使用;

周二,DeepSeek宣布开源DeepEP,即首个用于MoE模型训练和推理的开源EP通信库,提供高吞吐量和低延迟的all-to-all GPU内核;

周三,DeepSeek宣布开源DeepGEMM,该库同时支持密集布局和两种MoE布局,完全即时编译,为V3/R1模型的训练和推理提供强大支持;

周四,DeepSeek宣布开源Optimized Parallelism Strategies,主要针对大规模模型训练中的效率问题;

周五,DeepSeek宣布开源Fire-Flyer文件系统(3FS)以及基于3FS的数据处理框架Smallpond。

因此,有网友评论称:“《DeepSeek-V3/R1推理系统概览》技术文章是‘开源周’的彩蛋,直接亮出了DeepSeek的底牌!”

至此,DeepSeek“开源周”的连载或许告一段落,但DeepSeek的后续动作依然值得持续关注。

(文章来源:数据宝)

郑重声明:以上内容与本站立场无关。本站发布此内容的目的在于传播更多信息,本站对其观点、判断保持中立,不保证该内容(包括但不限于文字、数据及图表)全部或者部分内容的准确性、真实性、完整性、有效性、及时性、原创性等。相关内容不对各位读者构成任何投资建议,据此操作,风险自担。股市有风险,投资需谨慎。如对该内容存在异议,或发现违法及不良信息,请发送邮件至yxiu_cn@foxmail.com,我们将安排核实处理。